Introduction

Actuellement, vous observerez des visuels créés par des algorithmes tels que Stable Diffusion. Toutefois, la création de vidéos avec l'IA est un processus beaucoup plus difficile. En tant que personne travaillant dans une société de production médiatique, je peux affirmer avec assurance que la créativité générée par l’IA n’a pas encore atteint le niveau de qualité nécessaire à l’utilisation grand public de la génération de vidéos de diffusion.

Il existe une différence considérable entre les vidéos générées par l’IA et les normes de l’industrie. La diffusion stable ne se limite pas à la production d’images statiques ; il a le potentiel de créer des vidéos d’IA visuellement impressionnantes à l’aide de certains outils et extensions. Voici un guide simple pour créer des images pour un GIF animé ou une vidéo avec Stable Diffusion.

Dans cet article

La diffusion stable peut-elle générer de la vidéo ?

Oui, il est possible de créer des vidéos ou des GIF avec Stable Diffusion. Les dernières fonctionnalités d'img2img peuvent créer de courtes vidéos ou des GIF qui ressemblent à des vidéos. De plus, la technologie IA peut rapidement fournir des images animées pour la vidéo.

De plus, des outils spécialisés sont disponibles pour créer des vidéos à l'aide de la plateforme Stable Diffusion. Ces outils peuvent être utilisés pour générer des vidéos MP4 à l'aide de l'interface utilisateur Web.

La diffusion stable est-elle bonne ?

Une génération vidéo à diffusion stable est un outil exceptionnel pour produire des images magnifiques et réalistes. Même si son utilisation peut présenter des inconvénients, les avantages dépassent les éventuels impacts négatifs. En raison de sa commodité, de sa polyvalence et de ses résultats étonnants, Stable Diffusion est essentiel pour tous ceux qui aiment les visuels attrayants.

Stable Diffusion est une excellente ressource pour ceux qui cherchent à élargir leurs capacités artistiques. Il peut vous aider à trouver l’inspiration pour de nouveaux projets ou à explorer différents styles et techniques visuels.

Son interface conviviale vous permet de personnaliser les images que vous créez en fonction de vos spécifications.

Et vous n'avez pas besoin d'être un artiste expérimenté pour profiter de ses capacités : il est facile à utiliser quel que soit votre niveau de compétence. Avec Stable Diffusion, vous pouvez utiliser votre créativité pour produire des images et des designs époustouflants que vous montrerez fièrement.

Comment fonctionne la diffusion stable ?

Le concept de base de la génération d’images via des modèles de diffusion repose sur le fait que des modèles avancés de vision par ordinateur peuvent être entraînés avec suffisamment de données. Stable Diffusion offre une approche puissante à ce problème, en utilisant un algorithme pour générer une image basée sur des paramètres spécifiques.

L'algorithme de diffusion stable génère une vidéo initie le processus avec une image de bruit aléatoire continuellement affinée à l'aide d'une technique de diffusion spéciale. Le résultat est une création visuellement attrayante et haute résolution qui ressemble à celle d’un artiste talentueux. Voici le processus :

1. Départ vers l’espace latent :

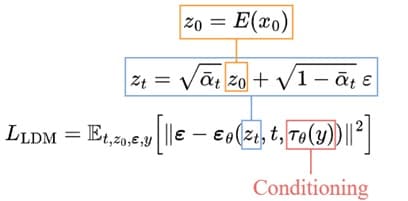

Le processus commence par la formation d’un auto-encodeur pour coder les images dans des représentations latentes de dimension inférieure. Il peut ensuite utiliser l'encodeur entraîné, E, pour convertir les images originales en versions compressées plus petites. Le décodeur entraîné, D, peut reconstruire l'image originale à partir des données latentes.

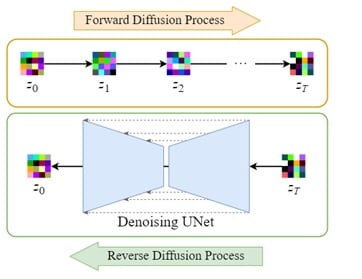

2. Diffusion latente :

Le processus de diffusion directe consiste à ajouter du bruit aux données latentes codées, tandis que le processus de diffusion inverse consiste à éliminer ce bruit des mêmes données. Cela garantit que les images peuvent être transformées à leur forme originale.

3. Conditionnement :

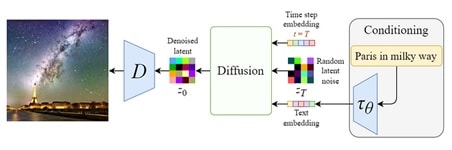

Le modèle de génération vidéo à diffusion stable exploite la capacité de générer des images à partir d'invites textuelles en augmentant le débruitage U-Net avec un mécanisme d'attention croisée.

Cela se fait en fournissant au modèle interne des entrées de conditionnement, telles que des incorporations de texte générées par un modèle de langage tel que BERT ou CLIP, et d'autres entrées spatiales telles que des images ou des cartes. Selon le type d'entrée de conditionnement, elle est soit mappée dans le U-Net via la couche Attention, soit ajoutée par concaténation.

4. Formation et échantillonnage :

L'objectif de la formation est similaire au modèle de diffusion de base, avec quelques modifications : en prenant en compte les données latentes zₜ plutôt que l'image xₜ, le U-Net comprend également une entrée de conditionnement 𝜏θ ( y ). La procédure de débruitage sera beaucoup plus rapide car les données latentes sont beaucoup plus petites que la photo initiale.

Comment réaliser une vidéo avec une diffusion stable ?

Deforum Stable Diffusion est une version spécialisée conçue pour créer des clips vidéo et des transitions à l'aide d'images générées par Stable Diffusion. Les personnes de tout niveau de compétence ou d'expertise peuvent utiliser cet outil logiciel open source piloté par la communauté.

Les développeurs sont toujours prêts à accepter de nouvelles contributions si vous souhaitez participer au projet. Le pipeline de génération vidéo de diffusion stable Deforum vous permet de réaliser des simulations complètes sans utiliser votre GPU.

• Générer une vidéo à l'aide de Deforum

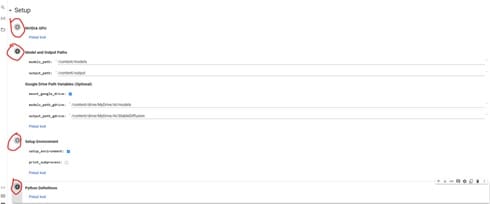

Pour copier Deforum stable diffusion generate video v0.5 sur votre Google Drive, cliquez sur le bouton " Copier dans Drive ". Une fois cela fait, vous recevrez une nouvelle copie du bloc-notes Colab sur votre propre Google Drive et pourrez ensuite fermer l'original, car vous n'en aurez plus besoin.

• Étape 1 : Installer l'extension Deforum

Actuellement, vous pouvez profiter pleinement de Google Colab et le connecter à un GPU externe. Sachez que vous recevez des crédits gratuits pour Google Colab ; cependant, si vous les épuisez, vous devez soit en acheter davantage, soit attendre quelques jours pour qu'ils soient restaurés.

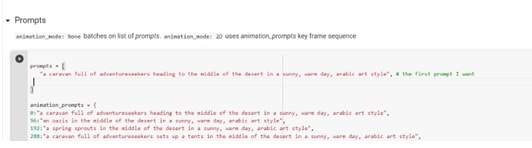

• Étape 2 : Rédigez vos invites

L'utilisation de modèles de génération vidéo à diffusion stable (ou tout autre LLM) pour l'ingénierie ou le développement de nos techniques de communication est de plus en plus importante aujourd'hui.

Il est recommandé de fournir des invites détaillées et spécifiques lors de la génération d'images pour obtenir les effets souhaités. Il est également important de fournir un aperçu de tous les paramètres ou effets d’animation souhaités, tels que l’éclairage, l’heure de la journée, le style artistique ou les références culturelles.

Éviter les titres d'œuvres ou laisser tomber les noms d'artistes est important, mais pour certains projets, cela peut produire des résultats intéressants. Lors de la génération d'une animation, fournissez toujours la première invite et toutes les invites supplémentaires avant de commencer.

Testez d'abord les invites, puis utilisez celles qui fonctionnent le mieux dans l'animation finale. Avec les techniques appropriées, les créateurs peuvent obtenir les effets souhaités pour une animation réussie.

• Étape 3 : Ajuster les paramètres de Deforum

Il est suggéré d'utiliser l'option override_with_file dans la génération de vidéo à diffusion stable, afin que vos paramètres soient toujours enregistrés et puissent être réutilisés, partagés ou rétablis. Pour les images 9:16, essayez 448 x 706 ; pour la verticale, 706 x 448 ; pour le carré, 512 x 512.

Dans les paramètres d'échantillonnage, entrez un nombre dans la ligne de départ si vous aimez une certaine image ou -1 pour aléatoire. Pour la valeur de pas, une plage comprise entre 50 et 60 est suggérée. Enfin, la valeur de l'échelle peut être réglée entre 7 et 12.

• Étape 4 : Générez votre vidéo

La dernière étape après la génération des vidéos consiste à télécharger les images et à les saisir dans un programme de montage vidéo approprié avant de restituer la vidéo. Un logiciel gratuit pour cela est DaVinci Resolve 18, qui offre une gamme de fonctionnalités pour vous donner plus de contrôle sur le produit final.

Alternativement, le code « créer une vidéo à partir d'images » peut être utilisé, mais cela ne donne pas toujours le résultat souhaité.

Comment écrire des invites de diffusion stables

Si vous avez utilisé des outils de génération d'images d'IA tels que Stable Diffusion, DALL-E ou MidJourney, vous comprendrez à quel point la formulation correcte est essentielle lorsque vous proposez une invite. Une invite précise et approfondie peut transformer n'importe quelle idée en une image époustouflante, tandis qu'une phrase vague peut donner lieu à une image bizarre et troublante. Voici quelques conseils :

1. Soyez précis : la génération vidéo à diffusion stable prospère lorsqu'elle est fournie avec des instructions concrètes, par rapport à MidJourney, qui est plus ouvert. Pour générer des paysages avec Stable Diffusion, vous devez être détaillé dans vos instructions, en utilisant des mots qui décrivent avec précision l'image que vous recherchez.

Expérimentez avec différentes phrases et voyez quel type de résultats elles donnent. Il est utile d'observer comment la modification de quelques mots-clés peut radicalement changer l'image et les intégrer dans l'invite pour obtenir le résultat souhaité.

2. Soyez sûr du style artistique et de la créativité : en plus d'indiquer le contenu de l'image souhaitée, vous devez également spécifier le style que vous souhaitez. Par exemple, si vous recherchez une apparence semblable à celle d'une peinture acrylique, votre invite devrait lire quelque chose comme « nom, peinture acrylique » ou « nom, style acrylique. »

Cette formule offre les meilleures chances de se rapprocher du style que vous recherchez. La diffusion stable a différents looks et styles : dessins au crayon, modèles en argile et même rendus 3D avec Unreal Engine.

3. Incluez le nom de l'artiste pour plus de clarté : une diffusion stable est une excellente option si vous souhaitez évoquer le style d'un artiste spécifique dans une œuvre. C'est un outil puissant qui peut véritablement capturer l'essence d'un artiste particulier si vous lui fournissez la bonne invite.

Vous pouvez même combiner différents artistes, produisant une fusion unique des styles des deux artistes. Cette expérimentation artistique peut donner des résultats passionnants et inattendus, alors n'ayez pas peur d'essayer la génération de vidéos de diffusion.

4. Analysez vos mots-clés : si vous devez mettre davantage l'accent sur un certain mot-clé dans l'invite, Stable Diffusion propose des options de pondération. Cette fonctionnalité vous permet d'attribuer une plus grande importance à certains mots par rapport à d'autres pour des résultats plus précis. Ceci est particulièrement utile lorsque le résultat est presque correct mais pourrait bénéficier d’une attention plus ciblée sur un terme spécifique.

5. Autres références : Récemment, il y a eu une énorme augmentation de la quantité d’art IA disponible en ligne. Tout le monde produit ce genre de pièces, et nombre de ces créations incluent les mots-clés ou les formules utilisés pour les générer. Il indique plusieurs images générées par les utilisateurs sur le Web, s'élevant facilement à des millions.

Paramètres techniques supplémentaires pour la génération d'invites :

Créer une invite efficace est la partie la plus difficile de l’utilisation de Stable Diffusion ; cependant, l'ajustement d'autres paramètres peut avoir un impact considérable sur le résultat.

- CFG : ce paramètre définit le niveau de confiance dont dispose l'IA à diffusion stable pour générer une réponse qui reflète avec précision votre invite. Augmenter la valeur permettra à l'IA de générer des invites plus fidèles, tandis que diminuer la valeur donnera à l'IA plus de latitude pour exercer son autonomie dans le texte généré. Testez différentes valeurs pour voir la plage de sorties que vous obtenez.

- Approche d'échantillonnage : l'image est nettoyée des interférences et transformée en modèles identifiables à l'aide de divers algorithmes, tels que Euler_a, k_LMS et PLMS, qui sont largement utilisés pour la génération vidéo à diffusion stable.

- Étapes d'échantillonnage : le nombre d'itérations pour atteindre la version finale d'une image peut varier. En général, moins d’étapes donnent des résultats satisfaisants, tandis qu’un nombre plus élevé peut ne pas conduire à une amélioration supplémentaire. Il est souvent recommandé de commencer par un nombre d’étapes relativement faible, en augmentant progressivement si nécessaire. Aller au-delà de 150 itérations n’entraîne généralement aucune amélioration supplémentaire.

Conclusion

Créer une vidéo en temps réel avec une génération vidéo à diffusion stable peut être assez laborieux et prendre du temps. Au fil des progrès technologiques, il devrait cependant devenir plus simple de créer des vidéos avec la diffusion stable qu'il ne l'est aujourd'hui de générer des images. En attendant, les utilisateurs doivent se servir de divers sous-outils et commandes qui peuvent ne pas être compréhensibles pour tous les utilisateurs.

FAQ

-

Pouvez-vous animer avec Stable Diffusion ?

La création d'animations peut se faire de plusieurs manières. Stability AI permet aux utilisateurs d'utiliser ses modèles Stable Diffusion, tels que Stable Diffusion 2.0 et Stable Diffusion XL, pour la création d'animations. De plus, les utilisateurs peuvent utiliser le point de terminaison d'animation pour accéder aux modèles prédéfinis, leur permettant ainsi de créer des animations rapidement et en plus grande quantité. -

Que peut générer la diffusion stable ?

Stable Diffusion est un générateur d'images IA qui peut être personnalisé à votre guise. Il dispose d'une plate-forme open source qui vous permet de créer vos ensembles de données et d'ajuster les images générées. De plus, vous pouvez entraîner vos modèles pour créer des images qui correspondent à vos préférences. -

La diffusion stable est-elle réservée aux images ?

Stable Diffusion est une méthode qui permet de créer des images à partir de descriptions textuelles. Il s'agit d'un choix supérieur à Mid-Jourray et DALLE-2, car il peut traduire avec précision le texte en visuels. Ceci est réalisé grâce à des algorithmes sophistiqués et à un réseau neuronal convolutif, qui convertit le contenu écrit en une image correspondante.